En la era actual, caracterizada por un crecimiento exponencial en el volumen de datos, especialmente los no estructurados como texto, imágenes, audio y video, las bases de datos tradicionales enfrentan limitaciones significativas en su capacidad para procesar y extraer valor de esta información. La gestión de datos estructurados ha sido históricamente el dominio de las bases de datos relacionales, que sobresalen en la organización de información en formatos de filas y columnas. Sin embargo, el manejo de vastos conjuntos de datos no estructurados, que crecen entre un 30% y un 60% anualmente, se vuelve un proceso intensivo en mano de obra y computacionalmente ineficiente para los sistemas convencionales, particularmente en el contexto de las aplicaciones de inteligencia artificial (IA).

Esta transformación en la naturaleza de los datos ha impulsado la emergencia de un nuevo paradigma en la gestión de la información: las bases de datos vectoriales. Estos sistemas están específicamente diseñados para almacenar, indexar y consultar representaciones numéricas de datos, conocidas como incrustaciones o embeddings, que capturan el significado semántico del contenido original. La capacidad de estas bases de datos para manejar eficientemente estas representaciones de alta dimensión es fundamental para el avance de la inteligencia artificial, permitiendo a las máquinas comprender y relacionar información de una manera más contextual y humana. La evolución de los datos de formatos estructurados a no estructurados ha impulsado la necesidad de nuevos paradigmas de bases de datos. Tradicionalmente, las bases de datos relacionales manejaban datos estructurados eficientemente. Sin embargo, el volumen masivo de datos no estructurados ha hecho que su manejo con métodos tradicionales para IA sea laborioso, llevando a la emergencia de bases de datos vectoriales, diseñadas para gestionar representaciones numéricas de datos no estructurados sin perder su significado semántico.

El propósito de este artículo es ofrecer una explicación exhaustiva de las bases de datos vectoriales. Se explicará su funcionamiento, su importancia crítica en el procesamiento del lenguaje natural (NLP) y en arquitecturas avanzadas como la Generación Aumentada por Recuperación (RAG). Además, se explorarán las bases de datos vectoriales más populares en el mercado, se explicará cómo PostgreSQL, a través de su extensión pgvector, puede ser utilizado para búsquedas vectoriales, y se analizarán en profundidad las métricas de distancia fundamentales, como la distancia Euclidiana y la similitud del coseno, que subyacen a las búsquedas de similitud.

¿Qué son las bases de datos vectoriales?

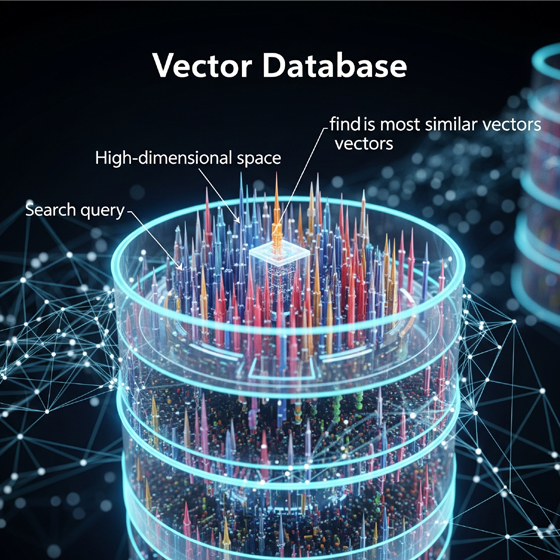

Una base de datos vectorial es un sistema de gestión de datos especializado diseñado para almacenar, indexar y consultar incrustaciones vectoriales, que son representaciones numéricas de datos no estructurados como texto, imágenes o audio. A diferencia de las bases de datos tradicionales que organizan la información en tablas o documentos, las bases de datos vectoriales operan con vectores matemáticos que representan los datos en espacios multidimensionales.

A. Vectores y embeddings: La representación numérica de los datos

En el corazón de una base de datos vectorial se encuentran los vectores y los embeddings. Un vector es, en esencia, una lista de números que expresa la ubicación de un punto flotante a lo largo de múltiples dimensiones. Cada vector dentro de una base de datos vectorial corresponde a un objeto o ítem específico, que puede ser una palabra, una imagen, un video, una película, un documento o cualquier otra pieza de datos. Estos vectores suelen ser largos y complejos, representando la ubicación de cada objeto a lo largo de docenas o incluso cientos de dimensiones. Por ejemplo, una base de datos vectorial de películas podría ubicar películas a lo largo de dimensiones como la duración, el género, el año de lanzamiento o el número de actores en común.

Los embeddings son un componente crucial, especialmente en el contexto de los modelos de aprendizaje profundo. Son vectores generados por redes neuronales o modelos de machine learning. Una vez que una red neuronal ha sido debidamente entrenada y ajustada, puede generar estos embeddings de forma automática, eliminando la necesidad de creación manual. El objetivo principal de los embeddings es capturar el significado semántico o las características clave de los datos. Diferentes modelos de embedding pueden representar los datos en distintos espacios vectoriales, que varían en el número de dimensiones, desde decenas hasta miles, donde la precisión de la representación aumenta con el incremento de las dimensiones.

B. El problema que resuelven las bases de datos vectoriales

Las bases de datos tradicionales, como las relacionales, sobresalen en la gestión de conjuntos de datos estructurados y semiestructurados en formatos específicos. Sin embargo, cargar fuentes de datos no estructurados en una base de datos relacional para almacenarlos, gestionarlos y prepararlos para la inteligencia artificial es un proceso laborioso. La búsqueda tradicional se basa en la coincidencia exacta de tokens discretos o características, como palabras clave o etiquetas. Por ejemplo, una búsqueda de «teléfono inteligente» solo devolvería resultados que contengan esa frase exacta.

Las bases de datos vectoriales abordan esta limitación de manera fundamental. Al representar los datos como vectores densos en un espacio vectorial continuo, permiten la búsqueda por similitud. Esto significa que una búsqueda de «teléfono inteligente» también podría devolver resultados para «celular» o «dispositivos móviles», ya que sus representaciones vectoriales capturan la similitud semántica. Esta capacidad de encontrar objetos similares de forma rápida y a escala es lo que impulsa la búsqueda semántica y la comprensión contextual en las aplicaciones modernas de IA. La capacidad de las bases de datos vectoriales para representar datos no estructurados como embeddings de alta dimensión, que conservan el significado semántico, es fundamental. Esto permite una «comprensión» contextual de los datos por parte de las máquinas, superando las limitaciones de la búsqueda tradicional basada en palabras clave. La relevancia de los resultados de búsqueda mejora drásticamente, lo que es crucial para aplicaciones impulsadas por IA que requieren una comprensión matizada del lenguaje natural.

Importancia en el procesamiento del lenguaje natural (NLP)

Las bases de datos vectoriales son un recurso invaluable en el ámbito del Procesamiento del Lenguaje Natural (NLP), donde la comprensión del significado y el contexto es primordial. Su diseño inherente para manejar representaciones semánticas las convierte en una herramienta eficaz para las aplicaciones de IA que interactúan con el lenguaje humano.

A. Búsqueda semántica y comprensión contextual

Una de las aplicaciones más destacadas de las bases de datos vectoriales en NLP es la búsqueda semántica. A diferencia de la búsqueda tradicional basada en palabras clave, que se limita a coincidencias literales, la búsqueda semántica impulsada por vectores permite encontrar contenido basándose en el significado conceptual y el contexto. Esto es crucial para superar limitaciones como errores tipográficos o el uso de sinónimos, ya que el sistema comprende la intención del usuario más allá de las palabras exactas. Por ejemplo, en un sistema de búsqueda de documentos, una consulta puede encontrar documentos relevantes incluso si no contienen las palabras clave exactas, siempre que el significado sea similar.

B. Gestión eficiente de «embeddings»

Las bases de datos vectoriales están optimizadas para el almacenamiento, la indexación y la recuperación de embeddings, lo que es fundamental para el rendimiento de los modelos de IA. Los embeddings de texto, generados por modelos de lenguaje, codifican las relaciones semánticas entre palabras, frases o documentos completos. Almacenar y gestionar estos embeddings de manera eficiente permite a los sistemas de IA acceder rápidamente a la «memoria» contextual necesaria para tareas complejas. La capacidad de las bases de datos vectoriales para almacenar y gestionar de manera eficiente las incrustaciones de texto es la piedra angular de su importancia en el NLP. Esto no solo acelera la recuperación de información, sino que también permite a los sistemas de IA ir más allá de la coincidencia literal de palabras clave, comprendiendo la intención y el contexto subyacentes. Esta funcionalidad es indispensable para construir sistemas de IA conversacionales y de comprensión del lenguaje natural verdaderamente sofisticados.

C. Aplicaciones prácticas en NLP

La aplicación de bases de datos vectoriales en NLP es vasta y transformadora:

- Chatbots y Asistentes de IA: Permiten a los chatbots y asistentes virtuales tener una «memoria» contextual, buscando mensajes del historial de chat o documentos relevantes para la conversación actual, lo que les permite proporcionar respuestas más pertinentes y fácticas.

- Sistemas de Preguntas y Respuestas: Combinando la conversión de documentos a embeddings de texto con el NLP moderno, las bases de datos vectoriales pueden proporcionar respuestas de texto completas a preguntas complejas, ahorrando a los usuarios la necesidad de revisar manuales extensos.

- Análisis de Sentimientos y Traducción: La capacidad de las bases de datos vectoriales para reflejar enlaces semánticos intrincados que los modelos de datos tradicionales no pueden capturar, permite una comprensión más matizada del lenguaje, mejorando la eficiencia en tareas como el análisis de tono y el contexto en aplicaciones de NLP.

- Sistemas de Recomendación: Al entender la similitud semántica, pueden recomendar productos, contenido o usuarios basándose en patrones de comportamiento o contextuales similares.

En resumen, las bases de datos vectoriales son críticas en actividades de NLP como la similitud de documentos, el análisis de sentimientos y la búsqueda semántica. Facilitan la indexación y recuperación eficiente de material textual codificado como embeddings de palabras o vectores de oraciones, permitiendo una comprensión más profunda del lenguaje.

Bases de datos vectoriales populares en el mercado

El creciente ecosistema de soluciones de bases de datos vectoriales, tanto comerciales como de código abierto, subraya su importancia en la gestión de datos para aplicaciones de IA. La elección de una solución adecuada depende de factores como la compatibilidad con la infraestructura existente, las consideraciones de costos y la complejidad de las cargas de trabajo de IA.

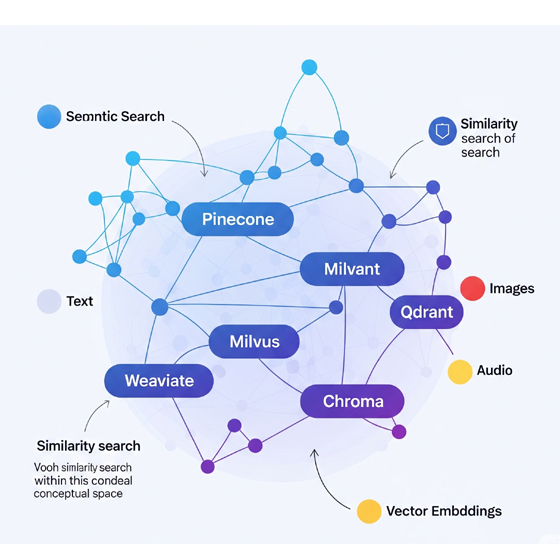

A. Bases de datos vectoriales dedicadas

Estas soluciones están construidas desde cero para optimizar el almacenamiento y la consulta de datos vectoriales, ofreciendo alto rendimiento y escalabilidad:

- Pinecone: Es un servicio gestionado en la nube, reconocido por su excepcional velocidad de consulta y baja latencia, lo que lo hace ideal para cargas de trabajo empresariales. Ofrece alta precisión con compensaciones configurables entre recuperación y rendimiento, y optimiza la eficiencia del almacenamiento mediante compresión vectorial. Su robusto soporte de metadatos lo hace adecuado para aplicaciones empresariales y listas para producción.

- Weaviate: Una base de datos vectorial de código abierto con soporte integrado para búsqueda híbrida y GraphQL. Destaca por sus APIs amigables que facilitan la integración y ofrece vectorización automática a través de modelos de machine learning integrados. Está diseñado para una escalabilidad óptima y eficiencia, con un fuerte soporte para metadatos y actualizaciones en tiempo real.

- Milvus: Otra opción de código abierto, Milvus está diseñada para manejar datos vectoriales a gran escala, ofreciendo un rendimiento excelente con aceleración por GPU, consultas distribuidas e indexación eficiente. Es altamente configurable y soporta una variedad de métodos de indexación como IVF, HNSW y PQ, permitiendo a los usuarios equilibrar precisión y velocidad. Su escalabilidad y soporte multilingüe lo hacen adecuado para empresas que buscan analizar grandes volúmenes de datos.

- Qdrant: Un motor de búsqueda vectorial de código abierto conocido por su rapidez, escalabilidad y altas tasas de recuperación utilizando métodos ANN avanzados. Permite métricas de distancia personalizables y ofrece eficiencia de almacenamiento mejorada con un diseño compacto y soporte para búsqueda híbrida. Es altamente flexible y compatible con Python y JavaScript.

- Chroma: Una base de datos vectorial de código abierto diseñada para consultar embeddings vectoriales de alta dimensión. Su API intuitiva simplifica la integración, haciéndola accesible para desarrolladores. Ofrece alta precisión y es adecuada para cargas de trabajo de pequeñas a medianas, ideal para prototipos y experimentación con modelos de IA.

- Vespa: Se destaca por su precisión en casos de uso híbridos, combinando datos estructurados, texto y búsqueda vectorial. Ofrece indexación optimizada y es altamente flexible para soportar algoritmos de clasificación personalizados y cargas de trabajo mixtas.

- Deep Lake: Especializado en el manejo de datos no estructurados y multimodales (imágenes, videos). Ofrece operaciones vectoriales decentes con un enfoque principal en conjuntos de datos multimodales, alta recuperación y eficiencia de almacenamiento optimizada para este tipo de datos. Se integra estrechamente con PyTorch y TensorFlow.

B. Extensiones para bases de datos de propósito general

Para organizaciones que ya utilizan bases de datos relacionales o NoSQL, existen opciones para integrar capacidades vectoriales sin una migración completa de su pila de datos:

- pgvector (para PostgreSQL): Esta es una extensión de código abierto que añade soporte para operaciones vectoriales y búsquedas por similitud directamente en PostgreSQL. Permite a los usuarios almacenar, indexar y consultar datos vectoriales dentro de su base de datos PostgreSQL existente.

- Elasticsearch u OpenSearch con plugin k-NN: Para empresas que ya utilizan estas plataformas, un plugin k-NN (k-Nearest Neighbors) puede transformarlas en sistemas capaces de manejar vectores, evitando la necesidad de reconstruir toda la pila de datos.

- MongoDB: Ha integrado capacidades de búsqueda vectorial en su ecosistema, lo que permite a las empresas aprovechar la búsqueda vectorial ligera junto con la funcionalidad de base de datos convencional.

C. Librerías de búsqueda de similitud

Además de las bases de datos completas, existen librerías que proporcionan algoritmos de búsqueda de similitud eficientes:

- FAISS (Facebook AI Similarity Search): Desarrollada por Meta, es una librería popular conocida por sus algoritmos eficientes para la búsqueda de similitud y el clustering de vectores densos. Aunque no es una base de datos completa por sí misma, es ampliamente utilizada en entornos de investigación y producción.

La diversidad de soluciones en el mercado, desde bases de datos vectoriales dedicadas hasta extensiones para bases de datos de propósito general y bibliotecas, refleja la maduración del campo. La elección de la solución adecuada depende de factores críticos como la escala de los datos, los requisitos de rendimiento, la infraestructura existente y la necesidad de control sobre la gobernanza de los datos. Esto subraya la importancia de una evaluación cuidadosa para alinear la tecnología con los objetivos empresariales y técnicos.

Cómo funcionan las búsquedas vectoriales (especialmente con RAG)

Las bases de datos vectoriales son el motor detrás de la búsqueda por similitud, una capacidad fundamental para las aplicaciones modernas de IA. El proceso implica varias etapas clave, desde la preparación de los datos hasta la recuperación de resultados, y es particularmente relevante en arquitecturas como la Generación Aumentada por Recuperación (RAG).

A. Proceso general de búsqueda por similitud

La búsqueda por similitud vectorial permite encontrar contenido o datos similares basándose en sus representaciones vectoriales. A un alto nivel, el proceso se desarrolla de la siguiente manera:

Vectorización de Datos: Los datos no estructurados, como texto, imágenes o audio, se convierten primero en una representación numérica, conocida como vectores o embeddings, utilizando un modelo de aprendizaje profundo. El objetivo de este paso es capturar la «semántica» o las características clave de estos datos, transformando el contenido en un formato comprensible para la máquina.

Almacenamiento e Indexación: Una vez generados, los vectores se almacenan en una base de datos vectorial, a menudo junto con referencias a sus datos originales. Para permitir búsquedas rápidas a escala, las bases de datos vectoriales emplean algoritmos de indexación especializados, comúnmente conocidos como algoritmos de Búsqueda de Vecinos Más Cercanos Aproximados (ANN, por sus siglas en inglés). Estos índices organizan los vectores de manera que se puedan recuperar eficientemente los objetos de datos a gran escala.

Consulta del Usuario: Cuando un usuario realiza una consulta, esta se convierte primero en su representación vectorial utilizando el mismo modelo de embedding que se usó para los datos almacenados.

Cálculo de Similitud: El vector de consulta se compara con los vectores indexados en la base de datos utilizando una métrica de distancia (o similitud) adecuada. El objetivo es encontrar los vectores que son «más cercanos» o más similares al vector de consulta en el espacio multidimensional.

Ranking y Recuperación: La lista de resultados devueltos corresponde a los vectores que se encontraron más cercanos. Estos resultados suelen clasificarse en función de su puntuación de similitud, mostrando primero los elementos más relevantes.

B. Algoritmos de indexación para búsqueda de vecinos más cercanos aproximados (ANN)

Para lograr la velocidad y eficiencia necesarias en la búsqueda de similitud en conjuntos de datos masivos y de alta dimensionalidad, las bases de datos vectoriales implementan algoritmos ANN. Estos algoritmos sacrifican una pequeña cantidad de precisión por ganancias significativas en velocidad, lo que es aceptable para la mayoría de las aplicaciones de IA. Los más importantes incluyen:

- HNSW (Hierarchical Navigable Small World): Este es un algoritmo basado en grafos que construye una jerarquía de grafos. En lugar de un solo grafo, HNSW mantiene múltiples capas de grafos. La capa superior contiene muy pocos nodos y las conexiones más largas, mientras que las capas más profundas incluyen progresivamente más nodos, con la capa inferior conteniendo todos los nodos y las conexiones más cortas. Durante el proceso de búsqueda, se ingresa en un punto predefinido en la capa más alta y se avanza de forma «codiciosa» (greedy) hacia el vecino más cercano al vector de consulta, descendiendo a las capas inferiores a medida que se refina la búsqueda. HNSW es muy eficaz en términos de velocidad y precisión, lo que lo convierte en un algoritmo de búsqueda vectorial robusto.

- LSH (Locality-Sensitive Hashing): LSH es una técnica de hashing difuso que mapea elementos de entrada similares en los mismos «cubos» con alta probabilidad. A diferencia del hashing convencional que minimiza las colisiones, LSH las maximiza para elementos similares. Esto permite reducir la dimensionalidad de los datos de alta dimensión, transformándolos en versiones de menor dimensión mientras se preservan las distancias relativas entre los ítems. El algoritmo construye múltiples tablas hash, cada una correspondiente a una función hash elegida aleatoriamente. Para una consulta, se recuperan los puntos de datos que se hashean en el mismo cubo, lo que reduce drásticamente el espacio de búsqueda.

- PQ (Product Quantization): Es un método de compresión con pérdida que convierte cada vector de un conjunto de datos en una representación corta y eficiente en memoria, llamada «código PQ». La esencia de PQ es descomponer el espacio vectorial de alta dimensión en el producto cartesiano de subespacios y luego cuantificar estos subespacios por separado. Cada subvector se codifica con el ID del centroide al que pertenece. Esto permite una compresión masiva de los vectores de la base de datos (a veces más del 95%), lo que reduce significativamente el uso de memoria. Aunque es un método con pérdida y puede resultar en una menor precisión de predicción, en la práctica funciona muy bien para la búsqueda de similitud.

La implementación de algoritmos de búsqueda de vecinos más cercanos aproximados (ANN) como HNSW, LSH y PQ es crucial para el rendimiento de las bases de datos vectoriales a escala. Estos algoritmos permiten una compensación entre la precisión y la velocidad, lo que es esencial para manejar miles de millones de vectores en aplicaciones en tiempo real. La elección del algoritmo de indexación impacta directamente en la eficiencia y la calidad de los resultados de búsqueda, un equilibrio delicado que los ingenieros deben gestionar.

C. Búsquedas vectoriales en el contexto de RAG

La Generación Aumentada por Recuperación (RAG, por sus siglas en inglés) es una arquitectura fundamental para mejorar las capacidades de los Grandes Modelos de Lenguaje (LLMs), proporcionándoles información relevante y actualizada de fuentes de datos externas. Los LLMs tienen un «corte de conocimiento» (conocimiento limitado a sus datos de entrenamiento), pueden «alucinar» hechos y no pueden acceder a datos propietarios a menos que se les proporcionen explícitamente. Aquí es donde las bases de datos vectoriales juegan un papel esencial.

La implementación de RAG con una base de datos vectorial típicamente implica los siguientes pasos:

- Indexación de la Base de Conocimientos: Los documentos o la base de conocimientos se dividen en fragmentos (chunks) más pequeños (por ejemplo, 200-500 palabras). Cada fragmento se convierte en una incrustación vectorial (embedding) utilizando un modelo de embedding (por ejemplo, OpenAI

text-embedding-3-smallobge-base). Estos embeddings, junto con los metadatos relevantes (como el título o las etiquetas), se almacenan en la base de datos vectorial. - Manejo de la Consulta del Usuario: Cuando un usuario envía una consulta, esta se convierte también en una incrustación vectorial utilizando el mismo modelo de embedding.

- Recuperación de Información Relevante: La base de datos vectorial se consulta para encontrar los fragmentos de conocimiento más relevantes (los vectores más similares) a la consulta del usuario. Esta búsqueda de similitud es la función principal de la base de datos vectorial en RAG.

- Aumento del Prompt: La información recuperada de la base de datos vectorial se añade al prompt original del usuario, sirviendo como contexto adicional para el LLM.

- Generación de Respuesta: El LLM genera entonces una respuesta basada tanto en su conocimiento preentrenado como en el contexto recuperado, lo que resulta en respuestas más precisas, actualizadas y fundamentadas.

Las bases de datos vectoriales son la «capa de memoria» de los sistemas RAG, permitiendo que los LLMs accedan a información externa y propietaria en tiempo real, superando sus limitaciones de conocimiento y reduciendo las «alucinaciones». Esto las hace esenciales para construir aplicaciones de IA contextualmente conscientes, precisas y escalables, desde asistentes de conocimiento interno hasta agentes de soporte al cliente.

PostgreSQL y búsquedas vectoriales: «pgvector»

PostgreSQL, una de las bases de datos relacionales de código abierto más populares y robustas, ha extendido sus capacidades para incluir la búsqueda vectorial a través de la extensión pgvector. Esta integración permite a los usuarios aprovechar las funcionalidades de las bases de datos vectoriales sin la necesidad de adoptar un sistema de base de datos completamente nuevo.

A. ¿Qué es pgvector?

pgvector es una extensión de código abierto para PostgreSQL que añade soporte nativo para operaciones vectoriales y búsquedas por similitud. Esto significa que los usuarios pueden almacenar, indexar y consultar datos vectoriales directamente dentro de su base de datos PostgreSQL existente, lo que simplifica la arquitectura de las aplicaciones de IA y reduce la complejidad de la gestión de datos.

B. Características clave de pgvector

pgvector introduce funcionalidades específicas para el manejo de vectores:

- Tipo de Dato

VECTOR(dimensions):pgvectorañade un nuevo tipo de datoVECTOR(dimensions), dondedimensionsespecifica el número de dimensiones del vector. Por ejemplo, se puede crear una tablaembeddingscon una columnavectorde 3 dimensiones:

CREATE TABLE embeddings (

id SERIAL PRIMARY KEY,

vector VECTOR(3)

);Esta extensión permite almacenar y buscar embeddings de diferentes dimensiones y tipos de datos, incluyendo texto, imágenes y audio, con soporte para indexar vectores de hasta 2,000 dimensiones.

- Operadores de Similitud:

pgvectorofrece varios operadores para calcular distancias entre vectores y realizar búsquedas de similitud:

<->: Calcula la Distancia L2 (Euclidiana), que mide la distancia directa en línea recta entre vectores.<#>: Calcula el Producto Interno (Inner Product). Este operador está relacionado con la similitud del coseno y es útil para comparar la orientación de los vectores.<=>: Calcula la Distancia del Coseno (Cosine Distance), que es el complemento de la similitud del coseno.

Ejemplo de Consulta: Para buscar los 5 vectores más cercanos a un vector de consulta [0.2, 0.3, 0.4] utilizando la distancia L2, la consulta SQL sería:

SELECT id, vector, vector <-> '[0.2, 0.3, 0.4]' AS distance

FROM embeddings

ORDER BY distance

LIMIT 5;Esta consulta ordena los resultados de menor a mayor distancia, mostrando primero los vectores más similares.

Integración con Frameworks de ML: pgvector puede integrarse con frameworks populares para el desarrollo de aplicaciones con LLMs, como LangChain, facilitando la construcción de sistemas de IA.

C. Comparación de pgvector con bases de datos vectoriales dedicadas

La integración de pgvector en PostgreSQL representa un enfoque híbrido, ofreciendo una solución conveniente para incorporar capacidades de búsqueda vectorial. Sin embargo, es importante comprender sus fortalezas y limitaciones en comparación con las bases de datos vectoriales dedicadas:

| Característica | pgvector (Extensión para PostgreSQL) | Bases de Datos Vectoriales Dedicadas (ej. Pinecone, Milvus, Weaviate) |

| Tipo de Base de Datos | Extensión para PostgreSQL (relacional) | Base de datos vectorial especializada |

| Despliegue | Autoalojado (funciona con la pila PostgreSQL existente) | Autoalojado o en la nube (servicios gestionados) |

| Escalabilidad | Limitado por la escalabilidad de PostgreSQL (adecuado para datasets pequeños) | Altamente escalable, diseñado para volúmenes masivos de datos |

| Integración | Funciona con la pila PostgreSQL existente, fácil integración | Requiere integración separada con sistemas existentes |

| Costo | Gratuito, de código abierto | Precios de pago por uso o costos de infraestructura |

| Funcionalidades | Operaciones vectoriales básicas, sin opciones de indexación avanzadas | Funciones avanzadas, esquema dinámico, indexación optimizada (HNSW, PQ, IVF) |

| Rendimiento | Adecuado para datasets pequeños, no optimizado para alta velocidad/concurrencia | Diseñado para alta velocidad, baja latencia y consultas concurrentes |

| Eficiencia de Almacenamiento | Limitada por la arquitectura de base de datos de propósito general | Optimizado para almacenamiento eficiente de vectores |

La capacidad de pgvector para integrar la búsqueda vectorial directamente en PostgreSQL ofrece una conveniencia y una reducción de costos significativas para los usuarios existentes. Esto facilita la adopción de capacidades de IA sin una migración completa de la base de datos. Sin embargo, esta conveniencia tiene un límite en la escalabilidad y el rendimiento. Para cargas de trabajo de IA intensivas, las bases de datos vectoriales dedicadas ofrecen un rendimiento superior debido a sus optimizaciones específicas y algoritmos de indexación avanzados. Esto plantea una decisión estratégica entre la simplicidad de la integración y la necesidad de un rendimiento especializado a gran escala.

Métricas de distancia en búsquedas vectoriales

En la búsqueda vectorial, la relevancia de los resultados se determina midiendo la similitud o disimilitud entre los vectores de consulta y los vectores almacenados. Para comparar dos vectores y cuantificar su similitud, se utilizan diversas medidas de distancia o similitud. Las más comunes son la distancia Euclidiana y la similitud del coseno.

A. Distancia euclidiana (L2)

La distancia Euclidiana, también conocida como distancia L2, mide la distancia en línea recta entre dos puntos en un espacio multidimensional. Su nombre proviene del antiguo matemático griego Euclides, a quien a menudo se le conoce como el «padre de la geometría».

Fórmula Matemática: Para dos vectores P = (p₁, p₂,…, pₙ) y Q = (q₁, q₂,…, qₙ) en un espacio n-dimensional, la distancia Euclidiana se calcula como:

\[d(\mathbf{p},\mathbf{q}) = \sqrt{\sum_{i=1}^{n} (q_i – p_i)^2}\]Esta fórmula puede extenderse a espacios de dimensiones superiores simplemente añadiendo más términos para cada dimensión adicional.

Interpretación: Una distancia Euclidiana más pequeña entre dos vectores indica una mayor similitud entre ellos. El rango de la distancia Euclidiana es de [0, ∞], donde un valor de 0 significa que los vectores son idénticos.

Cuándo y Por Qué Utilizarla: La distancia Euclidiana es adecuada cuando la magnitud o la proximidad absoluta de los vectores es un factor importante para determinar la similitud. Funciona de manera más efectiva en espacios de menor dimensionalidad y es sensible a la escala o magnitud de los vectores, lo que significa que las diferencias en la longitud de los vectores impactarán directamente en la distancia calculada. Se utiliza comúnmente en algoritmos de clustering, clasificación y reducción de dimensionalidad, donde la proximidad física en el espacio vectorial es una representación directa de la similitud.

B. Similitud del coseno

La similitud del coseno es una medida de la similitud entre dos vectores en un espacio multidimensional, que se calcula como el coseno del ángulo entre ellos. Esta métrica indica cuán estrechamente se alinean los vectores entre sí, es decir, su orientación, independientemente de su magnitud.

Fórmula Matemática: La similitud del coseno (cos(θ)) entre dos vectores A y B se calcula como el producto punto (dot product) de los dos vectores dividido por el producto de sus magnitudes (normas):

\[d_{\text{cosine}}(\mathbf{A},\mathbf{B}) = 1 – \frac{\mathbf{A} \cdot \mathbf{B}}{||\mathbf{A}|| \cdot ||\mathbf{B}||}\]Donde A ⋅ B representa el producto punto de los vectores A y B, y ||A|| y ||B|| son las magnitudes (longitudes) de los vectores A y B, respectivamente.

Interpretación: El rango de la similitud del coseno es de [-1, 1]:

- 1: Indica que los vectores están perfectamente alineados, apuntando en la misma dirección, lo que representa una alta similitud.

- 0: Indica que los vectores son ortogonales (perpendiculares entre sí), lo que implica que no hay similitud direccional.

- -1: Indica que los vectores apuntan en direcciones completamente opuestas, representando una alta disimilitud. Es importante señalar que algunas implementaciones, como Weaviate, utilizan la «distancia del coseno», que es el complemento de la similitud del coseno y tiene un rango de , donde 0 significa idéntico y 2 significa opuesto.

Cuándo y Por Qué Utilizarla: La similitud del coseno es particularmente útil cuando la orientación o la relación direccional entre los vectores es más importante que sus magnitudes absolutas. Es insensible a la magnitud del vector, lo que la hace ideal para escenarios donde la longitud del vector (como la longitud de un documento) no debe influir en la similitud temática. Es muy adecuada para datos de alta dimensionalidad y datos dispersos, como los que se encuentran en el análisis de texto (similitud de documentos), el procesamiento del lenguaje natural (NLP) y los sistemas de recomendación. Además, maneja bien la ortogonalidad y requiere que los vectores estén normalizados para obtener resultados precisos.

C. Comparación detallada: Distancia euclidiana vs. similitud del coseno

La elección entre la distancia Euclidiana y la similitud del coseno no es arbitraria; depende fundamentalmente del significado semántico que se atribuye a la magnitud (longitud) de un vector versus su dirección (orientación).

- Sensibilidad a la Magnitud: La distancia Euclidiana es sensible a la magnitud de los vectores; los vectores más largos naturalmente tendrán distancias Euclideanas mayores, incluso si su orientación es similar. Por el contrario, la similitud del coseno es insensible a la magnitud, centrándose únicamente en el ángulo entre ellos. Esto es crucial en el análisis de texto, donde un documento más largo (mayor magnitud) no implica necesariamente que sea menos similar en tema a uno más corto.

- Dimensionalidad: La similitud del coseno es generalmente más adecuada para espacios de alta dimensionalidad y datos dispersos (por ejemplo, datos de texto), donde la distancia Euclidiana puede ser menos efectiva debido a la «maldición de la dimensionalidad». En espacios de muy alta dimensión, todos los puntos tienden a estar aproximadamente a la misma distancia entre sí, lo que hace que la distancia Euclidiana sea menos discriminatoria. La distancia Euclidiana, por su parte, funciona mejor en espacios de menor dimensionalidad.

- Casos de Uso:

- Euclidiana: Es ideal cuando la proximidad absoluta es crucial, como en el cálculo de distancias físicas, en la agrupación de datos donde el tamaño o la escala de las características son significativos, o en la detección de anomalías donde la magnitud de la desviación es crítica.

- Coseno: Se prefiere cuando la similitud de contenido o tema es la clave, independientemente de la longitud o frecuencia de los documentos. Por ejemplo, dos documentos extensos sobre el mismo tema tendrán una alta similitud del coseno, incluso si su distancia Euclidiana es grande debido a su longitud.

- Complejidad Computacional: En altas dimensiones, la similitud del coseno puede ser menos intensiva computacionalmente que la distancia Euclidiana, ya que no requiere la operación de raíz cuadrada, lo que puede ser una ventaja en sistemas de gran escala.

La selección de la métrica de distancia es una decisión crítica que debe alinearse con el significado semántico deseado de la «similitud» en un contexto de datos específico. Si la magnitud del vector (por ejemplo, la longitud de un documento) es una característica relevante para la similitud, la distancia Euclidiana es adecuada. Si la dirección o el tema son primordiales, independientemente de la magnitud, la similitud del coseno es la elección superior. Esta consideración directa afecta la relevancia de los resultados de búsqueda y subraya la necesidad de una comprensión profunda de los datos y los objetivos de la aplicación.

Conclusión y perspectivas futuras

Las bases de datos vectoriales han surgido como una tecnología fundamental en el panorama de la inteligencia artificial, abordando el desafío inherente de gestionar y extraer valor de los voluminosos y crecientes conjuntos de datos no estructurados. Al transformar datos complejos como texto, imágenes y audio en representaciones numéricas de alta dimensión (embeddings), estas bases de datos permiten una comprensión semántica que trasciende las limitaciones de la búsqueda tradicional basada en palabras clave. Esta capacidad es indispensable para el procesamiento del lenguaje natural (NLP), donde facilitan la búsqueda semántica, la gestión eficiente de embeddings y la potenciación de aplicaciones como chatbots inteligentes, sistemas de recomendación y plataformas de preguntas y respuestas.

El mercado de bases de datos vectoriales es vibrante y diverso, ofreciendo desde soluciones dedicadas de alto rendimiento como Pinecone, Weaviate y Milvus, hasta extensiones para bases de datos de propósito general como pgvector para PostgreSQL, y librerías de búsqueda de similitud como FAISS. Esta variedad permite a las organizaciones elegir la solución que mejor se adapte a sus necesidades específicas, equilibrando factores como la escalabilidad, el costo, la complejidad de la implementación y la integración con la infraestructura existente. La existencia de múltiples enfoques subraya la importancia de una evaluación cuidadosa para alinear la tecnología con los objetivos empresariales y técnicos.

El funcionamiento de las búsquedas vectoriales se basa en un pipeline sofisticado que incluye la vectorización de datos, su almacenamiento e indexación eficiente mediante algoritmos de Búsqueda de Vecinos Más Cercanos Aproximados (ANN) como HNSW, LSH y PQ, y el cálculo de la similitud con métricas adecuadas. Estos algoritmos son cruciales para lograr un equilibrio entre velocidad y precisión en la gestión de miles de millones de vectores. En el contexto de la Generación Aumentada por Recuperación (RAG), las bases de datos vectoriales actúan como una «capa de memoria» externa, permitiendo a los Grandes Modelos de Lenguaje (LLMs) acceder a información actualizada y específica del dominio, lo que mejora drásticamente la precisión y la relevancia de sus respuestas y reduce las «alucinaciones».

Finalmente, la comprensión de las métricas de distancia, como la distancia Euclidiana y la similitud del coseno, es fundamental para el diseño efectivo de sistemas de búsqueda vectorial. La elección de la métrica adecuada depende directamente del significado semántico que se desea capturar: la distancia Euclidiana es sensible a la magnitud y es ideal cuando la proximidad absoluta es clave, mientras que la similitud del coseno se centra en la orientación y es preferible para datos de alta dimensionalidad como el texto, donde la dirección temática es más importante que la longitud del vector. Esta decisión impacta directamente en la relevancia de los resultados de búsqueda y en el rendimiento general de los sistemas de IA.

De cara al futuro, las bases de datos vectoriales se consolidan como la «capa de memoria» esencial para la IA generativa, un componente crítico para la evolución continua de modelos de lenguaje más capaces y contextualmente conscientes. Se espera una continua evolución en los algoritmos de indexación para mejorar aún más la velocidad y la precisión, así como una creciente integración de las capacidades vectoriales en bases de datos de propósito general, democratizando el acceso a estas poderosas funcionalidades. Para cualquier profesional que trabaje con grandes conjuntos de datos y sistemas de IA, una comprensión profunda de las bases de datos vectoriales es crucial para optimizar la búsqueda y el análisis de datos, mejorar la eficiencia de los sistemas y facilitar el desarrollo de aplicaciones avanzadas e innovadoras.

——————————————————–

Fuentes: