Los datos atípicos, o outliers, son observaciones que se desvían significativamente de la mayoría de los datos en un conjunto. Su naturaleza es dual: pueden ser el resultado de errores de medición o entrada de datos, o representar eventos genuinos y raros que contienen información valiosa. Esta ambigüedad es fundamental, ya que su tratamiento incorrecto puede distorsionar los análisis estadísticos, sesgar las predicciones de los modelos de machine learning, reducir su precisión y comprometer su interpretabilidad.

El presente informe explora en profundidad la definición y tipología de los outliers, detalla su impacto crítico en el entrenamiento de modelos de machine learning y presenta un abanico de métodos para su detección, desde técnicas estadísticas tradicionales hasta algoritmos avanzados de aprendizaje automático. Asimismo, se analizan las estrategias para mitigar su influencia negativa, como la eliminación, transformación o el capping, y se destaca cómo, en contextos como la detección de fraude, los outliers dejan de ser un desafío para convertirse en el objetivo principal del análisis, representando las señales críticas de actividad anómala. La comprensión y gestión adecuada de los outliers son, por tanto, pilares esenciales para la fiabilidad y eficacia de los sistemas de machine learning en el mundo real.

1. Introducción a los datos atípicos (Outliers)

1.1. ¿Qué son los outliers? Definición y características clave

Los datos atípicos, comúnmente conocidos como outliers, son puntos de datos que se encuentran a una distancia anormalmente grande del resto de los valores en un conjunto de datos determinado. Estos valores pueden ser considerablemente más altos o más bajos que la mayoría de las observaciones y tienen la capacidad de influir en los resultados del análisis de datos de maneras que tergiversan la muestra original. En esencia, un outlier es una anomalía que cae fuera del rango esperado para una variable específica.

Las características fundamentales de los outliers incluyen su notable diferencia numérica respecto a otras observaciones. Su presencia puede alterar significativamente las conclusiones estadísticas, como la media o la mediana, debido a su influencia desproporcionada en los cálculos. Además, los outliers pueden originarse por diversas razones, como la variabilidad genuina inherente a los datos, errores en los procesos de medición o fallos durante la entrada de datos. A menudo, representan ocurrencias raras en relación con la población de datos completa.

La relevancia de los outliers en el análisis de datos es innegable y su papel varía en función de su origen y el impacto que generen en el análisis. En ciertos campos, los outliers pueden ofrecer información crucial sobre eventos poco comunes, indicando la necesidad de un análisis más exhaustivo. Por ejemplo, en el sector de la salud, un dato atípico en el historial de un paciente podría señalar un conjunto anormal de síntomas o un patrón de recuperación inusual, lo que justificaría una investigación adicional para comprender mejor posibles resultados o condiciones. Sin embargo, en otros escenarios, los outliers pueden ser meros indicadores de errores, como imprecisiones de medición, errores tipográficos o la introducción de «ruido» en el conjunto de datos que no representa la realidad subyacente. La existencia de outliers también puede ser una señal de baja calidad de los datos y puede introducir sesgos en el análisis, lo que exige una decisión informada sobre cómo proceder.

La distinción entre un outlier que es «ruido» y uno que es una «señal» es fundamental. Si bien la mayoría de los outliers pueden ser variaciones sin sentido o errores de medición, algunos pueden representar una señal verdadera, es decir, eventos genuinos y significativos. Por ejemplo, un valor de IQ extremadamente alto para un individuo particular es un outlier, pero si la medición es precisa, es una señal verdadera de una capacidad excepcional. Por el contrario, una medición de IQ de 90 para la misma persona sería ruido si su IQ real es mucho mayor. Esta naturaleza dual implica que un enfoque único para el manejo de los outliers, como eliminarlos indiscriminadamente, es inadecuado y podría ser perjudicial. La decisión sobre cómo tratar un outlier debe basarse en una investigación exhaustiva de su causa y contexto, lo que requiere un juicio experto y un profundo conocimiento del dominio. Esto transforma la gestión de outliers de una tarea puramente técnica a una que exige una comprensión contextual profunda.

1.2. Tipos de outliers: Globales, contextuales y colectivos

Los outliers se pueden clasificar en diferentes categorías según sus características y la forma en que se desvían de la mayoría de los datos. Esta clasificación es crucial para seleccionar los métodos de detección y tratamiento más apropiados.

- Outliers Globales: Son puntos de datos que se desvían significativamente de todo el conjunto de datos. Suelen ser los más fáciles de identificar porque se encuentran muy lejos del clúster principal de puntos de datos. Un ejemplo claro sería un cliente bancario que habitualmente deposita no más de $2,000 al mes en cheques en un cajero automático, pero de repente realiza dos depósitos en efectivo de $10,000 cada uno en un lapso de dos semanas. Este evento constituye una anomalía global en el historial de depósitos del cliente, ya que nunca antes había ocurrido algo similar.

- Outliers Contextuales (o Condicionales): Estos outliers se consideran anómalos basándose en un contexto específico. Esto implica que el mismo valor podría no ser considerado un outlier si ocurriera en un contexto diferente. Un ejemplo ilustrativo es una temperatura alta que es normal en verano, pero se consideraría anómala en invierno. Otro caso podría ser un aumento repentino en las admisiones diarias de pacientes en un hospital durante un brote de enfermedad como el COVID-19 o un desastre natural. Aunque el número de admisiones podría ser alto, es un outlier contextual en términos de utilización hospitalaria solo bajo esas circunstancias específicas.

- Outliers Colectivos: Se refieren a un conjunto de puntos de datos que, en su conjunto, se comportan de manera diferente al resto del conjunto de datos. Individualmente, estos puntos podrían no parecer anómalos, pero cuando se consideran como un grupo, forman un patrón atípico. En el ámbito de las redes sociales, un ejemplo podría ser un video o un hashtag que se vuelve viral y recibe un número inusualmente alto de «me gusta», «compartidos» o comentarios en un corto período. Individualmente, cada «me gusta» no es un outlier, pero el patrón colectivo de un aumento masivo de interacciones sí lo es.

La clasificación de los outliers en globales, contextuales y colectivos no es meramente una cuestión de taxonomía; tiene implicaciones directas en la elección de los métodos de detección. Los outliers globales a menudo pueden ser identificados con métodos estadísticos simples, ya que su desviación es evidente en todo el conjunto de datos. Sin embargo, los outliers contextuales y colectivos exigen técnicas más sofisticadas que puedan considerar el tiempo, las relaciones entre variables o los patrones grupales. Por ejemplo, para detectar una anomalía en las ventas de un comercio durante el Black Friday, no basta con comparar las ventas con el promedio anual; se debe considerar el contexto de la temporada de ofertas. Esto subraya que no existe un método de detección universalmente aplicable. La efectividad de la detección depende de la capacidad del método para capturar la «anomalía» en su contexto específico, lo que añade una capa de complejidad al proceso de análisis de datos y requiere un conocimiento profundo de la naturaleza de los datos y del problema a resolver.

1.3. Causas comunes de los outliers

Los outliers pueden surgir por una variedad de razones, que van desde errores simples hasta eventos genuinamente raros y significativos. Comprender la causa subyacente de un outlier es fundamental para determinar la estrategia de manejo más apropiada. Las causas más comunes incluyen:

- Errores de Medición: Estos outliers son resultado de imprecisiones en los instrumentos o procesos utilizados para recopilar datos. Por ejemplo, un sensor defectuoso podría registrar lecturas de temperatura inusualmente altas o bajas.

- Errores de Entrada de Datos: Son fallos humanos o automatizados que ocurren durante la transcripción, carga o procesamiento de los datos. Un error tipográfico al introducir un valor numérico, como escribir «1900» en lugar de «190», puede generar un outlier significativo.

- Variaciones Genuinas o Eventos Raros: Estas observaciones son verdaderamente inusuales pero válidas, reflejando la variabilidad natural del fenómeno estudiado o la ocurrencia de eventos extremos. Por ejemplo, un pico inusual en el tráfico de un sitio web durante un evento mediático imprevisto sería un outlier genuino.

- Errores Experimentales o Introducción Intencional: Pueden derivar de fallos en la planificación o ejecución de un experimento. En algunos casos, los outliers pueden incluso ser introducidos deliberadamente para probar la robustez de métodos estadísticos o modelos de machine learning.

- Inclusión de Puntos de Datos Irrelevantes: Esto ocurre cuando se incluyen en el conjunto de datos observaciones que no pertenecen a la población o contexto de interés. Por ejemplo, si se está analizando la altura promedio de estudiantes de secundaria y accidentalmente se incluyen datos de jugadores de baloncesto profesionales, sus alturas inusualmente elevadas generarían outliers en el conjunto de datos.

La recurrencia de estas causas en la literatura subraya un punto crítico: la decisión de cómo manejar un outlier debe precederse por una investigación sobre por qué existe. Si un outlier es claramente el resultado de un error, como un peso registrado que es físicamente imposible, su eliminación o corrección es justificada. Sin embargo, si el outlier representa un evento genuino y válido, debe ser considerado cuidadosamente o incluso aprovechado para obtener información valiosa. La «sobrecorrección», que implica la eliminación indiscriminada de outliers sin comprender su contexto, es un error común que puede ser tan perjudicial como ignorar las anomalías. Este enfoque transforma la gestión de outliers de una aplicación mecánica de reglas a un proceso de razonamiento crítico que integra el conocimiento del dominio. Ignorar la causa raíz puede llevar a la pérdida de información valiosa o a la introducción de sesgos en el modelo, comprometiendo la fiabilidad del análisis.

2. Impacto de los outliers en el entrenamiento de modelos de machine learning

Los outliers pueden ejercer una influencia profunda y multifacética en el rendimiento y la interpretabilidad de los modelos de machine learning. Su presencia puede distorsionar los patrones de aprendizaje y sesgar las predicciones, afectando la utilidad y fiabilidad del modelo.

2.1. Distorsión de resultados estadísticos y sesgo del modelo

Los outliers tienen la capacidad de afectar drásticamente los análisis estadísticos, especialmente aquellas medidas de tendencia central que son sensibles a valores extremos, como la media. Un valor inusualmente alto o bajo puede «tirar» la media hacia sí mismo, ofreciendo una representación falsa de la tendencia central del conjunto de datos. Esta distorsión puede desviar a los tomadores de decisiones si confían únicamente en medidas de tendencia central sin evaluar adecuadamente la dispersión o la asimetría de los datos.

En el contexto del machine learning, los outliers pueden distorsionar los patrones subyacentes en los datos, lo que lleva a modelos sesgados y predicciones inexactas. Esto ocurre porque el modelo, durante su entrenamiento, puede otorgar un peso indebido a estos puntos extremos, interpretándolos como parte del patrón general en lugar de como anomalías.

El sesgo inducido por los outliers no se limita a las predicciones inmediatas del modelo; se propaga a través de toda la cadena de valor de la toma de decisiones. Si las estadísticas descriptivas están sesgadas, las etapas posteriores del proceso de análisis de datos, como la ingeniería de características, la selección de modelos y el desarrollo de estrategias comerciales basadas en estos análisis, también serán inherentemente defectuosas. La distorsión en el análisis debido a los outliers puede resultar en conclusiones inexactas o implausibles, lo que a su vez conduce a decisiones políticas o empresariales erróneas. Esto se traduce en un desperdicio de recursos y la creación de ineficiencias operacionales. Por lo tanto, el costo de ignorar los outliers se extiende más allá de la precisión del modelo, afectando directamente los resultados empresariales y operacionales, lo que resalta la importancia estratégica de una gestión adecuada de los outliers.

2.2. Reducción de la precisión y generalización del modelo

Los outliers introducen ruido en el conjunto de datos, lo que puede interrumpir significativamente el proceso de entrenamiento del modelo, conduciendo a predicciones sesgadas y una precisión reducida. Los modelos de machine learning, especialmente aquellos que basan sus cálculos en promedios o distancias, como la regresión lineal o los k-vecinos más cercanos (KNN), pueden experimentar una disminución sustancial en su precisión si los outliers están presentes.

La presencia de outliers es una causa común de overfitting (sobreajuste), un fenómeno donde los modelos aprenden el ruido específico en los datos en lugar de capturar el patrón subyacente verdadero. Los modelos de alta dimensionalidad, como las redes neuronales profundas y los ensambles basados en árboles, pueden volverse excesivamente sensibles a estas observaciones extremas, lo que puede resultar en una confianza inflada en predicciones incorrectas. Además, los outliers aumentan la varianza en el conjunto de datos, lo que hace que el modelo sea menos estable y más propenso al sobreajuste. El sobreajuste a los outliers puede generar predicciones poco fiables en aplicaciones de alto riesgo, como el diagnóstico médico y la previsión financiera, donde la interpretabilidad y la fiabilidad son críticas.

La gestión de los outliers es fundamental para construir modelos robustos. Un modelo robusto es aquel que mantiene un rendimiento preciso y consistente incluso en conjuntos de datos que difieren de los datos de entrenamiento, incluyendo entradas ruidosas y outliers. A menudo, optimizar un modelo para la robustez puede implicar una precisión ligeramente menor en el conjunto de entrenamiento, pero un rendimiento significativamente mejor en datos no vistos y del mundo real. Esto plantea una decisión estratégica: ¿se debe priorizar la precisión bruta en un conjunto de entrenamiento potencialmente «limpio», o es más valioso construir un modelo más robusto, capaz de manejar la complejidad inherente de los datos del mundo real, incluidos los outliers legítimos? Para aplicaciones de alto riesgo, la robustez a menudo prevalece sobre la precisión máxima en el entrenamiento, ya que garantiza la fiabilidad del modelo en escenarios operativos.

2.3. Efectos en la interpretación del modelo y la importancia de las características

La presencia de outliers hace que las predicciones del modelo sean más difíciles de interpretar, ya que resulta complicado diferenciar entre los patrones verdaderos y el ruido introducido por estos valores anómalos. Las métricas de importancia de las características, que buscan cuantificar la contribución de cada variable a las predicciones del modelo, son particularmente vulnerables a la distorsión causada por los outliers. En los modelos lineales, los valores extremos ejercen una influencia indebida en los coeficientes estimados, lo que lleva a interpretaciones sesgadas de las contribuciones de los predictores. Por ejemplo, en la regresión por mínimos cuadrados ordinarios (OLS), los outliers pueden desplazar la línea de regresión estimada, tergiversando así el efecto de las variables explicativas. De manera similar, los modelos de regresión logística pueden asignar una importancia excesiva a características que co-ocurren frecuentemente con outliers, lo que resulta en interpretaciones erróneas de la significancia de las características.

En el caso de los modelos de «caja negra», los métodos de atribución de características como SHAP (SHapley Additive Explanations) y LIME (Local Interpretable Model-agnostic Explanations) son susceptibles de ser engañados por los outliers. Estas herramientas de interpretabilidad se basan en métodos de perturbación, y cuando se entrenan en conjuntos de datos que contienen outliers, pueden sobrestimar la importancia de ciertas características debido a la influencia de valores extremos. Como consecuencia, los tomadores de decisiones que dependen de estas explicaciones pueden ser engañados, lo que resulta en una confianza incorrecta en el proceso de decisión del modelo. Los outliers introducen sesgos en las explicaciones del modelo al alterar las clasificaciones de importancia de las características y generar interpretaciones engañosas.

La reducción de la interpretabilidad y la distorsión de la importancia de las características socavan directamente la confianza en el modelo y, por ende, en las decisiones basadas en sus explicaciones. Si los tomadores de decisiones son engañados por una importancia de características sesgada, pueden tomar decisiones estratégicas incorrectas. En industrias reguladas o aplicaciones de alto riesgo, como el diagnóstico médico o la previsión financiera, la interpretabilidad del modelo no es un «extra», sino un requisito regulatorio y ético. Los outliers, al comprometer este aspecto, plantean un riesgo significativo para el cumplimiento normativo y la rendición de cuentas, afectando la capacidad de validar y confiar en los resultados del sistema de machine learning.

2.4. Sensibilidad de algoritmos específicos

La sensibilidad de los algoritmos de machine learning a los outliers varía considerablemente, lo que influye directamente en la elección del modelo y en las estrategias de preprocesamiento de datos. Comprender esta sensibilidad es fundamental para construir modelos fiables.

Algoritmos sensibles a outliers:

- Regresión Lineal: Es altamente sensible a los outliers porque busca encontrar una línea de mejor ajuste que minimice la suma de los errores cuadrados. Los outliers pueden afectar significativamente la pendiente y la intersección de esta línea, llevando a un modelo inexacto. Asume una relación lineal entre la variable objetivo y los predictores.

- K-Means: Este algoritmo de aprendizaje no supervisado agrupa los datos basándose en la distancia entre ellos. La introducción de outliers puede alterar drásticamente la posición de los centroides de los clústeres, lo que a su vez cambia la asignación de puntos a los clústeres.

- K-Nearest Neighbors (KNN): KNN opera seleccionando los vecinos más cercanos basándose en la distancia. Un solo ejemplo mal etiquetado o una anomalía puede cambiar drásticamente los límites de clase, ya que el algoritmo obtiene toda su información directamente de la entrada sin intentar generalizar los datos.

- Redes Neuronales Artificiales (ANN) / Deep Learning: Estos modelos son sensibles porque utilizan el descenso de gradiente para converger rápidamente. Su alta flexibilidad y capacidad pueden llevar a un sobreajuste a los outliers, reduciendo la capacidad de generalización del modelo.

- PCA (Análisis de Componentes Principales): PCA es muy sensible a los outliers porque es un método basado en la matriz de correlación/covarianza, que es susceptible a valores extremos.

- AdaBoost: Este algoritmo asigna pesos a cada instancia en el conjunto de entrenamiento, enfocándose más en las instancias mal clasificadas. Los outliers pueden influir desproporcionadamente en estos pesos, lo que provoca un bajo rendimiento del modelo.

Algoritmos robustos a outliers:

- Regresión Logística: Generalmente se considera más robusta que la regresión lineal, ya que utiliza la función sigmoide para comprimir la magnitud de la función de costo entre 0 y 1. Sin embargo, puede ser sensible a outliers en las variables predictoras , y algunas fuentes sugieren que no es «muy robusta».

- SVM (Support Vector Machine): Utiliza un clasificador de margen máximo para clasificar los puntos, lo que la hace generalmente robusta. No obstante, al igual que la regresión logística, existen observaciones que sugieren que no es «muy robusta» a los outliers en ciertos contextos.

- Árboles de Decisión: Son robustos porque se construyen sobre condiciones simples de «si-entonces» y no se ven afectados por la magnitud de los valores extremos.

- Random Forest: Al ser un ensamble de árboles de decisión, hereda la robustez de sus componentes base, lo que lo hace resistente a los outliers.

- Boosting (e.g., Gradient Boosting): Los algoritmos de boosting suelen tener como aprendices base a los árboles de decisión, lo que los hace robustos a los outliers.

- Técnicas de Regresión Robusta: Métodos como el de las desviaciones absolutas mínimas reducen la sensibilidad a los outliers al minimizar funciones de pérdida alternativas que no penalizan excesivamente los errores grandes, a diferencia de los mínimos cuadrados tradicionales.

La comprensión detallada de la sensibilidad algorítmica es vital para la selección del modelo y la estrategia de preprocesamiento. Para algoritmos sensibles, se justifica un manejo más agresivo de los outliers, como su eliminación, capping o transformación.

3. Métodos de detección de outliers

La detección de outliers es un paso crítico para garantizar la calidad y precisión de los modelos de machine learning. Existen diversas técnicas, que abarcan desde métodos estadísticos tradicionales hasta algoritmos avanzados de aprendizaje automático, cada uno con sus propias fortalezas y casos de uso.

3.1. Técnicas estadísticas (Z-Score, IQR, Boxplots)

Estos métodos se basan en propiedades estadísticas de los datos para identificar puntos que se desvían de la norma. Son generalmente rápidos y fáciles de implementar, pero su rendimiento es óptimo con datos simples y directos.

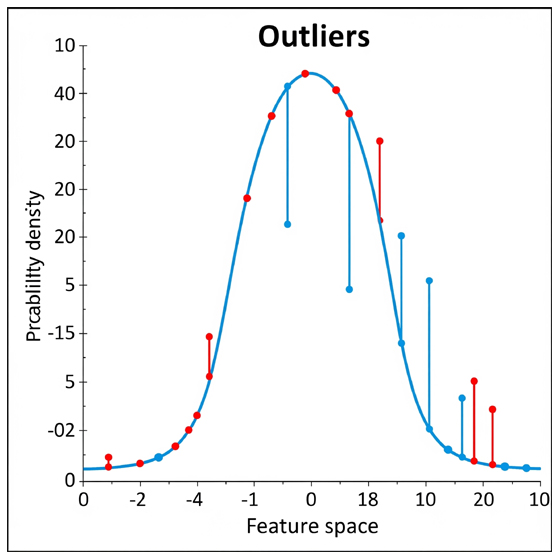

- Z-Score: Este método mide cuántas desviaciones estándar un punto de datos se encuentra de la media del conjunto. Un umbral comúnmente aceptado para considerar un outlier es un Z-score mayor de 3 o menor de -3. En una distribución normal, los valores con Z-scores más extremos que +/- 3 tienen una probabilidad de ocurrencia muy baja, aproximadamente 0.0027 (alrededor de 1 en 370 observaciones). La principal ventaja de este método es su simplicidad y efectividad para datos que siguen una distribución normal. Sin embargo, su principal limitación es su alta sensibilidad a las desviaciones de la normalidad , lo que puede llevar a una identificación errónea de outliers si los datos no son normales.

- Rango Intercuartílico (IQR): El método IQR define los outliers como cualquier punto de datos que se encuentra fuera de 1.5 veces el rango intercuartílico. El IQR se calcula como la diferencia entre el tercer cuartil (Q3) y el primer cuartil (Q1) de los datos. Los límites para los outliers se establecen como

Q1 - 1.5 * IQR(límite inferior) yQ3 + 1.5 * IQR(límite superior). Una ventaja significativa del IQR es su robustez frente a datos asimétricos y a la presencia de otros outliers, lo que lo hace más adecuado para distribuciones no normales. - Boxplots (Diagramas de Caja y Bigotes): Los boxplots son herramientas visuales que proporcionan una representación clara de la distribución de los datos y resaltan los outliers como puntos individuales que se encuentran fuera de los «bigotes» del diagrama. Son una forma rápida y efectiva de detectar anomalías visualmente, permitiendo una inspección inicial de la calidad de los datos.

tros métodos estadísticos incluyen la Desviación Absoluta Mediana (MAD), que utiliza la mediana en lugar de la media para ser más robusta a los outliers , la Prueba de Grubb, utilizada para detectar un solo outlier en un conjunto de datos univariado normalmente distribuido , y el Filtro de Hampel.

La efectividad de los métodos estadísticos depende críticamente de las asunciones sobre la distribución de los datos. La sensibilidad del Z-score a la normalidad de los datos implica que su aplicación ciega a datos no distribuidos normalmente puede llevar a una identificación errónea de outliers o a la omisión de anomalías verdaderas. En contraste, el IQR es notablemente robusto a datos asimétricos. Esto resalta la necesidad de una exploración preliminar de los datos, por ejemplo, utilizando histogramas o boxplots, para comprender su distribución antes de seleccionar un método de detección.

3.2. Métodos basados en distancia y densidad (KNN, LOF, DBSCAN)

Estos métodos determinan si un punto de datos es un outlier basándose en su distancia o densidad en relación con otros puntos de datos en el conjunto. Son particularmente útiles cuando la estructura de los datos es compleja y los outliers no son evidentes en dimensiones individuales.

- K-Nearest Neighbors (KNN): Este método identifica los outliers como puntos de datos cuyos K vecinos más cercanos están significativamente lejos de ellos. La lógica es que los outliers se encuentran aislados en el espacio de datos, con pocos vecinos cercanos dentro de una cierta distancia.

- Local Outlier Factor (LOF): LOF calcula la densidad local de los puntos de datos e identifica los outliers como aquellos con una densidad significativamente menor en comparación con sus vecinos. Un LOF alto indica una mayor probabilidad de que un punto sea un outlier, ya que está más aislado en su vecindario local. Este método es eficaz para identificar outliers en datos multidimensionales donde los métodos tradicionales podrían fallar.

- DBSCAN (Density-Based Spatial Clustering of Applications with Noise): DBSCAN es un algoritmo de clustering que agrupa los puntos de datos basándose en su densidad. Identifica los outliers como puntos que no pertenecen a ningún clúster denso, es decir, puntos que están en regiones de baja densidad.

A diferencia de los métodos estadísticos univariados como el Z-score o el IQR, los métodos basados en distancia y densidad consideran inherentemente el espacio multidimensional de los datos. Esto es crucial porque un outlier podría no ser extremo en ninguna característica individual, pero se vuelve anómalo cuando se considera su relación con otras características. Por ejemplo, un monto de transacción puede ser normal, pero ese monto combinado con un patrón de ubicación y tiempo altamente inusual podría ser un outlier en un contexto de detección de fraude. Para conjuntos de datos complejos y de alta dimensionalidad con muchas características, estos métodos son a menudo más efectivos que los umbrales estadísticos simples, ya que capturan la «inusualidad» en el contexto de la estructura inherente de los datos, lo cual es vital para una detección de anomalías sofisticada.

3.3. Algoritmos de machine learning (Isolation Forest, One-Class SVM, Autoencoders)

Estos métodos aprovechan la capacidad de los modelos de machine learning para aprender patrones de datos «normales» y luego identificar desviaciones de estos patrones aprendidos. Representan un enfoque más sofisticado y adaptable para la detección de outliers.

- Isolation Forest: Es un algoritmo de aprendizaje no supervisado altamente efectivo para la detección de anomalías. Funciona aislando anomalías mediante la selección aleatoria de una característica y la división de los datos. Los outliers requieren menos divisiones para ser aislados en un árbol de decisión, lo que los hace fáciles de detectar. Este algoritmo es eficiente y escalable, lo que lo hace adecuado para grandes conjuntos de datos.

- One-Class Support Vector Machine (OCSVM): OCSVM es un método de clasificación que aprende el comportamiento «normal» de los datos y establece un límite alrededor de estos datos normales. Cualquier punto que caiga fuera de este límite se identifica como un outlier.

- Autoencoders: Son redes neuronales no supervisadas que se utilizan principalmente para la extracción de características y la reducción de dimensionalidad, pero también son muy efectivas para la detección de anomalías. Se entrenan para reconstruir sus datos de entrada. Los datos normales tienen un error de reconstrucción mínimo, mientras que los outliers (anormales) tienen errores de reconstrucción altos, lo que indica que la red tiene dificultades para reconstruir el patrón anómalo. Son particularmente útiles para datos de alta dimensionalidad.

4. Estrategias para mitigar el impacto de los outliers

Una vez detectados, existen diversas estrategias para manejar los outliers, cada una con sus propias ventajas y desventajas. La elección de la estrategia debe ser cuidadosamente considerada, basándose en la naturaleza del outlier y los objetivos del análisis.

4.1. Eliminación (Trimming/Truncation)

La eliminación, también conocida como trimming o truncation, consiste en remover los outliers directamente del conjunto de datos. Esta estrategia es aceptable si el outlier es físicamente imposible o es claramente el resultado de un error de medición o entrada de datos. Por ejemplo, si el peso de una mujer se registra como 19 libras, es un valor físicamente imposible y su eliminación está justificada.

Sin embargo, la eliminación puede llevar a la pérdida de datos valiosos, haciendo que el conjunto de datos sea más pequeño y potencialmente menos representativo de la población real. No es justificable eliminar una observación solo porque es un outlier si esta es una observación legítima. Si los datos son limitados, la eliminación de outliers puede resultar en un conjunto de datos muy pobre. Además, esta práctica puede disminuir la probabilidad de encontrar diferencias estadísticamente significativas cuando estas existen en los datos.

La eliminación es un paso drástico e irreversible. Las fuentes reiteran constantemente el riesgo de eliminar datos valiosos, enfatizando que si un outlier es físicamente posible, debe considerarse. Se subraya que no es aceptable eliminar una observación solo porque es un outlier, ya que pueden ser observaciones legítimas y, a veces, las más interesantes. Esto implica que la eliminación debe ser un último recurso, reservado para puntos de datos claramente erróneos. Requiere una justificación cuidadosa y una documentación rigurosa para mantener la integridad y reproducibilidad de los datos. La decisión de eliminar datos siempre debe ser transparente y basarse en un sólido conocimiento del dominio, no solo en criterios estadísticos.

4.2. Transformación de datos (Logarítmica, Normalización, Escalado)

La transformación de datos implica el uso de métodos como el escalado, la normalización o la transformación logarítmica para reducir el efecto de los outliers sin eliminarlos del conjunto de datos.

- Transformación Logarítmica: Aplica una función logarítmica a los datos para comprimirlos y reducir el impacto de los valores extremos. Esta transformación es particularmente útil para datos que presentan una asimetría positiva (sesgo a la derecha), haciendo que la distribución sea más simétrica y, por lo tanto, más manejable para modelos que asumen normalidad.

- Normalización/Escalado: Estos métodos ajustan la escala de los datos, por ejemplo, a un rango de 0-1 (normalización Min-Max) o a una media de 0 y desviación estándar de 1 (estandarización Z-score). Al escalar los valores, los outliers se vuelven menos disruptivos para los modelos sensibles a la magnitud de los valores de las características.

Las transformaciones ofrecen una forma menos intrusiva de manejar los outliers en comparación con la eliminación. El beneficio clave es que las transformaciones retienen los puntos de datos outlier dentro del conjunto de datos, simplemente alterando su escala o distribución. Esto es crucial cuando el outlier podría contener información valiosa, pero su magnitud es problemática para el modelo. Por ejemplo, una transformación logarítmica puede hacer que una distribución altamente asimétrica sea más simétrica, reduciendo la influencia desproporcionada de los valores grandes sin descartarlos. Son particularmente útiles para modelos sensibles a la escala o a las suposiciones distribucionales, permitiendo que el modelo aprenda de todo el rango de datos mientras mitiga el apalancamiento indebido del outlier.

4.3. Capping (Winsorization)

El capping, también conocido como winsorization, es una técnica que consiste en establecer un umbral para limitar la influencia de los valores extremos, «tapándolos» en un cierto valor. En lugar de eliminar los valores extremos, estos son reemplazados por los valores de los percentiles más cercanos que no se consideran outliers (el mínimo y máximo recortado). Por ejemplo, un pedido de $29,000 que es un outlier extremo podría ser cambiado a un valor más representativo, como $800, si ese es el valor máximo «normal» en el percentil superior.

Las ventajas de esta técnica incluyen la retención de todos los puntos de datos en el conjunto, a la vez que se reduce significativamente el impacto de los outliers. Además, el capping preserva parte de la varianza original de los datos, a diferencia de la eliminación completa.

El capping o winsorization es un enfoque intermedio entre la eliminación y la transformación simple. Limita explícitamente la influencia de los valores extremos sin descartarlos por completo. Esto es particularmente útil cuando los outliers son legítimos, pero su magnitud pura dominaría el modelo. Al reemplazarlos con el valor no-outlier más cercano (o un percentil), efectivamente «acerca» los extremos, haciendo la distribución menos asimétrica y el modelo más estable, sin dejar de reconocer la existencia de valores altos o bajos. El capping es un enfoque pragmático cuando los outliers son genuinos pero su naturaleza extrema es problemática para el entrenamiento del modelo. Permite una reducción controlada de la influencia de los outliers, lo que puede ser beneficioso para modelos sensibles a valores extremos, pero donde la eliminación completa es indeseable.

4.4. Uso de modelos robustos al outlier

Una estrategia proactiva para mitigar el impacto de los outliers es la selección y el uso de algoritmos que son inherentemente menos sensibles a su presencia. Estos modelos están diseñados para manejar la variabilidad de los datos sin que los valores extremos distorsionen excesivamente sus parámetros o predicciones.

Ejemplos de algoritmos conocidos por su robustez incluyen los Árboles de Decisión, Random Forests y Gradient Boosting. Estos algoritmos basados en árboles son menos influenciados por la distribución de los datos y, por lo tanto, son más resistentes a los outliers. Otras técnicas incluyen la regresión robusta, como la regresión L1-regularizada o la regresión de Huber, y los M-estimadores, que estiman los parámetros del modelo basándose en una función objetivo robusta que reduce el peso de la influencia de los outliers. En el ámbito del clustering, algoritmos como DBSCAN son menos susceptibles a la presencia de outliers que K-means.

Los beneficios de utilizar modelos robustos son significativos: reducen la sensibilidad a los outliers y mejoran el rendimiento de generalización del modelo. Un modelo robusto es capaz de manejar escenarios inciertos del mundo real de manera apropiada, manteniendo un rendimiento consistente y preciso en diversas condiciones, incluso cuando los datos de entrada contienen ruido o outliers. Esto es fundamental para la fiabilidad operativa y la confianza en los sistemas de machine learning.

La gestión de outliers no es solo un paso de preprocesamiento, sino también una consideración en la selección del modelo. Al elegir algoritmos conocidos por ser robustos, los científicos de datos pueden mitigar proactivamente los problemas de outliers, lo que potencialmente reduce la necesidad de una manipulación exhaustiva de los datos. Este es un enfoque más integrado para tratar las anomalías de los datos. La robustez del modelo «reduce la sensibilidad a los outliers» y «mejora el rendimiento de generalización». Esto enfatiza que una estrategia holística para la gestión de outliers implica tanto el preprocesamiento de datos como una elección cuidadosa del algoritmo. Para ciertas aplicaciones o tipos de datos, seleccionar un modelo robusto desde el principio puede ser más eficiente y producir mejores resultados que intentar «arreglar» los datos para un modelo sensible.

5. Aprovechamiento de outliers para la detección de fraude

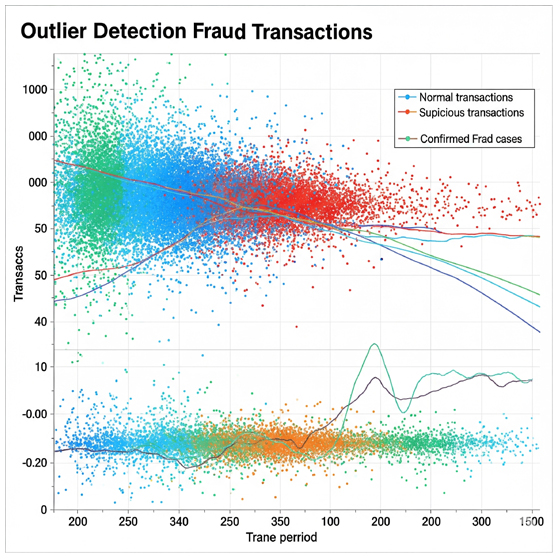

En el campo de la detección de fraude, la perspectiva sobre los outliers cambia fundamentalmente. Aquí, los outliers no son simplemente puntos de datos problemáticos a mitigar, sino que se convierten en las señales críticas que el sistema busca identificar.

5.1. Outliers como señales críticas de fraude

La detección de fraude es, en esencia, una aplicación de la detección de anomalías. En este contexto, los outliers representan eventos raros pero de suma importancia, como transacciones fraudulentas o patrones de comportamiento anómalos. A diferencia de otros campos del machine learning donde los outliers pueden ser indicativos de errores de medición o ruido que distorsionan el modelo, en la detección de fraude, los outliers son el objetivo principal del análisis.

Existe un cambio de paradigma fundamental: los outliers dejan de ser una amenaza para convertirse en una oportunidad. En lugar de mitigar su impacto negativo en la precisión del modelo, el objetivo principal es identificarlos y comprenderlos. Esto se debe a que las actividades fraudulentas suelen ser eventos poco frecuentes que se desvían drásticamente de los patrones de comportamiento «normales». Por lo tanto, el aspecto de «señal» de los outliers se vuelve primordial. La capacidad de un sistema para detectar con precisión estas desviaciones es lo que define su eficacia en la prevención del fraude.

5.2. Técnicas de machine learning en detección de fraude

El machine learning desempeña un papel crucial en la detección de fraude al permitir la identificación y el combate de actividades fraudulentas con mayor precisión y eficiencia. Se emplean diversas técnicas de aprendizaje automático para este fin:

- Aprendizaje Supervisado: Este método utiliza datos previamente etiquetados (donde se conoce si una transacción es fraudulenta o legítima) para entrenar modelos. Estos modelos aprenden a identificar patrones de fraude conocidos. Los algoritmos comunes en este enfoque incluyen árboles de decisión y máquinas de vectores de soporte (SVM).

- Aprendizaje No Supervisado: En situaciones donde los datos etiquetados son escasos o inexistentes, los algoritmos de aprendizaje no supervisado son indispensables. Estos descubren patrones dentro de los datos sin conocimiento previo de lo que constituye fraude, identificando outliers como desviaciones significativas de los patrones normales. Ejemplos incluyen el clustering K-means e Isolation Forests.

- Aprendizaje Semi-supervisado: Este enfoque combina elementos de aprendizaje supervisado y no supervisado. Utiliza una pequeña cantidad de datos etiquetados junto con grandes volúmenes de datos no etiquetados para detectar anomalías de manera más eficiente, lo cual es particularmente útil cuando los datos etiquetados son limitados.

Además de estos tipos principales, otras técnicas de machine learning como la extracción de características, la reducción de dimensionalidad y el aprendizaje por ensambles (como Random Forest o Boosting) mejoran aún más la precisión de la detección, convirtiendo estos sistemas en herramientas poderosas para combatir el fraude en tiempo real.

Las técnicas de machine learning, especialmente las no supervisadas y semi-supervisadas, son cruciales para adaptarse a los nuevos y evolutivos patrones de fraude que son inicialmente desconocidos. A diferencia de los sistemas basados en reglas fijas, que solo pueden detectar fraudes para los que han sido programados, los modelos de machine learning pueden aprender y adaptarse a comportamientos anómalos emergentes. Esta adaptabilidad es vital en un entorno donde los defraudadores modifican constantemente sus tácticas, lo que permite a los sistemas de detección de fraude mantenerse a la vanguardia.

5.3. Importancia de la robustez y la interpretación en detección de fraude

En aplicaciones críticas como la detección de fraude, la robustez y la interpretabilidad del modelo son tan importantes como su precisión.

- Robustez: La robustez del modelo es crucial para las aplicaciones en el mundo real, ya que garantiza que el sistema de detección de fraude mantenga un rendimiento consistente y preciso a pesar de las variaciones o el ruido en los datos de entrada. Un modelo robusto puede resistir ataques adversarios, donde los defraudadores intentan manipular intencionalmente los datos para eludir la detección. Esto es fundamental para la seguridad y la integridad de los sistemas financieros.

- Interpretabilidad: La interpretabilidad es crítica en aplicaciones de alto riesgo como las finanzas. No basta con que un modelo identifique una transacción como fraudulenta; es esencial comprender por qué se ha marcado. Los analistas humanos necesitan esta información para validar las alertas, refinar las reglas de detección, cumplir con las regulaciones y tomar decisiones informadas sobre las acciones a seguir. Si las explicaciones del modelo son sesgadas o difíciles de entender debido a la influencia de outliers, la confianza en el sistema disminuye y su utilidad práctica se ve comprometida.

La robustez del modelo asegura la fiabilidad operativa y fomenta la confianza del usuario. En el contexto de la detección de fraude, la interpretabilidad es esencial para que los analistas humanos puedan validar las alertas, refinar las reglas y cumplir con las regulaciones. Esto hace que el sistema no solo sea preciso, sino también accionable y confiable. Un sistema de detección de fraude que no es robusto puede ser engañado, y uno que no es interpretable puede generar falsos positivos o falsos negativos que los analistas no pueden comprender ni corregir, lo que lleva a ineficiencias operativas y riesgos financieros.

Conclusiones

Los datos atípicos, o outliers, son una característica omnipresente en los conjuntos de datos y su comprensión es fundamental para cualquier profesional de machine learning. Este informe ha detallado su naturaleza dual, revelando que pueden ser tanto indicadores de errores de datos como valiosas señales de eventos raros y significativos. Esta distinción es crucial, ya que un manejo indiscriminado puede llevar a la pérdida de información vital o a la introducción de sesgos perjudiciales.

El impacto de los outliers en el entrenamiento de modelos de machine learning es profundo y multifacético. Distorsionan las estadísticas descriptivas, sesgan los modelos, reducen la precisión predictiva y comprometen la capacidad de generalización, lo que puede resultar en sobreajuste y predicciones poco fiables en aplicaciones de alto riesgo. Además, la interpretabilidad del modelo se ve directamente afectada, lo que dificulta la comprensión de la importancia de las características y socava la confianza en las decisiones basadas en el modelo. La sensibilidad de los algoritmos varía, lo que subraya la necesidad de una selección de modelo informada y estrategias de preprocesamiento adaptadas.

La detección de outliers se logra mediante una variedad de métodos, desde técnicas estadísticas como el Z-score y el IQR, que requieren una comprensión de la distribución de los datos, hasta métodos basados en distancia y densidad como KNN, LOF y DBSCAN, que son más adecuados para datos multidimensionales. Los algoritmos de machine learning, como Isolation Forest, One-Class SVM y Autoencoders, representan la vanguardia al aprender la «normalidad» de los datos para identificar desviaciones sutiles.

Las estrategias para mitigar el impacto de los outliers incluyen la eliminación (reservada para errores claros e irreversibles), la transformación de datos (para preservar la información mientras se reduce la influencia), el capping (para limitar valores extremos sin descartarlos) y, fundamentalmente, el uso de modelos inherentemente robustos. La elección de la estrategia debe ser un acto deliberado, guiado por un análisis de la causa raíz del outlier y los objetivos del proyecto.

Finalmente, en el ámbito de la detección de fraude, los outliers se transforman de un problema a una solución. Aquí, las anomalías son precisamente las señales que el sistema busca identificar. Las técnicas de machine learning (supervisadas, no supervisadas y semi-supervisadas) son indispensables para adaptarse a los patrones de fraude en constante evolución. La robustez del modelo asegura su fiabilidad operativa y resistencia a ataques, mientras que la interpretabilidad es crucial para que los analistas humanos puedan validar y actuar sobre las alertas, manteniendo la confianza en el sistema.

En síntesis, la gestión de los outliers en machine learning es un proceso matizado que exige un equilibrio entre la precisión estadística, la robustez del modelo y la interpretabilidad contextual. No existe una solución única para todos los casos; en cambio, se requiere un enfoque holístico que integre el conocimiento del dominio, la exploración de datos y la selección cuidadosa de métodos de detección y estrategias de manejo. Una gestión experta de los outliers no solo mejora la calidad y el rendimiento de los modelos de machine learning, sino que también desbloquea el valor de los datos anómalos, transformándolos en inteligencia accionable, especialmente en campos críticos como la detección de fraude.

—————————————–

Fuentes: