Apache Spark es un motor de procesamiento de datos distribuido de código abierto diseñado para análisis de datos a gran escala. A diferencia de las soluciones de procesamiento tradicionales, Spark no solo maneja datos en reposo (almacenados), sino también datos en movimiento (streaming), lo que lo hace increíblemente versátil para diversas aplicaciones de big data. Se destaca por su velocidad, facilidad de uso y capacidades analíticas unificadas.

¿Para qué sirve Apache Spark?

Spark se utiliza para una amplia gama de tareas de procesamiento de datos a gran escala, incluyendo:

- Procesamiento de Big Data (Batch Processing): Realizar transformaciones y análisis en conjuntos de datos muy grandes que residen en sistemas de almacenamiento distribuidos como HDFS (Hadoop Distributed File System), Amazon S3 o Google Cloud Storage.

- Procesamiento de Streaming en Tiempo Real: Procesar flujos de datos en tiempo real (por ejemplo, datos de sensores, clics web, transacciones financieras) para análisis y alertas inmediatas.

- Machine Learning: Construir y entrenar modelos de machine learning a escala, gracias a su biblioteca MLlib, que ofrece una amplia gama de algoritmos.

- Procesamiento de Gráficos: Analizar relaciones en grandes conjuntos de datos representados como grafos, útil para redes sociales, sistemas de recomendación, etc., a través de su biblioteca GraphX.

- Consultas Interactivas: Realizar consultas ad-hoc y análisis exploratorio de datos de manera rápida, gracias a su capacidad de mantener datos en memoria.

- ETL (Extract, Transform, Load): Procesar y transformar grandes volúmenes de datos para cargarlos en data warehouses o bases de datos.

¿Qué lenguajes de programación soporta?

Apache Spark ofrece APIs en varios lenguajes de programación populares, lo que permite a los desarrolladores trabajar con sus herramientas preferidas:

- Scala: El lenguaje principal en el que está escrito Spark y su API más nativa.

- Java: Un lenguaje ampliamente utilizado en el ámbito empresarial, con un buen soporte de API.

- Python (PySpark): Extremadamente popular para ciencia de datos y machine learning debido a su facilidad de uso y la vasta cantidad de bibliotecas.

- R (SparkR): Para análisis estadístico y computación distribuida.

- SQL: A través de Spark SQL, los usuarios pueden interactuar con Spark utilizando consultas SQL estándar, lo que facilita la integración con herramientas de business intelligence.

Ventajas de Apache Spark

- Velocidad: Hasta 100 veces más rápido que Hadoop MapReduce para datos en memoria y 10 veces más rápido para datos en disco, gracias a su motor de ejecución en memoria.

- Facilidad de Uso: Ofrece APIs de alto nivel en varios lenguajes, simplificando el desarrollo de aplicaciones distribuidas.

- Capacidades Unificadas: Combina procesamiento por lotes, streaming, SQL, machine learning y procesamiento de grafos en una única plataforma.

- Tolerancia a Fallos: Proporciona tolerancia a fallos automática y recuperación de errores eficiente.

- Flexibilidad: Puede ejecutarse en Hadoop YARN, Apache Mesos, Kubernetes o de forma autónoma, y puede acceder a diversas fuentes de datos.

- Gran Comunidad y Ecosistema: Cuenta con una comunidad activa y un amplio ecosistema de herramientas y bibliotecas.

Desventajas o ¿Cuándo no usarlo?

- Consumo de Memoria: Si bien su fuerza es el procesamiento en memoria, esto puede ser una desventaja si los conjuntos de datos son extremadamente grandes y no caben en la RAM disponible, lo que puede llevar a derrames a disco y una degradación del rendimiento.

- Curva de Aprendizaje (para optimización): Aunque es fácil de empezar, optimizar aplicaciones Spark para un rendimiento óptimo en grandes clústeres puede requerir un conocimiento profundo de su arquitectura y configuración.

- Costos de Infraestructura: El uso extensivo de memoria puede implicar costos más altos de hardware (servidores con mucha RAM) o servicios en la nube.

- No es una base de datos: Spark es un motor de procesamiento, no una base de datos. No almacena datos de forma persistente por sí mismo, sino que procesa datos de otras fuentes.

- Latencia para tareas muy pequeñas: Para tareas de procesamiento de datos con latencia extremadamente baja (milisegundos) en conjuntos de datos muy pequeños, una base de datos NoSQL o una solución de message queueing podría ser más adecuada.

- Casos de uso sencillos: Para análisis de datos pequeños que pueden manejarse con herramientas tradicionales en una sola máquina, Spark podría ser una sobreingeniería innecesaria.

Reseña Histórica

Apache Spark fue creado por Matei Zaharia en el AMPLab de la Universidad de California, Berkeley, en 2009. La idea original surgió de la necesidad de un motor de procesamiento de datos más rápido y flexible que Hadoop MapReduce, especialmente para cargas de trabajo iterativas y análisis interactivos.

- 2009: Nace como un proyecto de investigación en el AMPLab.

- 2010: Es lanzado como un proyecto de código abierto.

- 2013: Se convierte en un proyecto de nivel superior de la Apache Software Foundation, lo que marcó un hito importante en su adopción y desarrollo.

- Desde entonces: Ha experimentado un crecimiento exponencial, con el desarrollo de componentes clave como Spark SQL, Spark Streaming, MLlib y GraphX, consolidándose como una de las tecnologías más importantes en el ecosistema de Big Data.

Principios Arquitectónicos Fundamentales

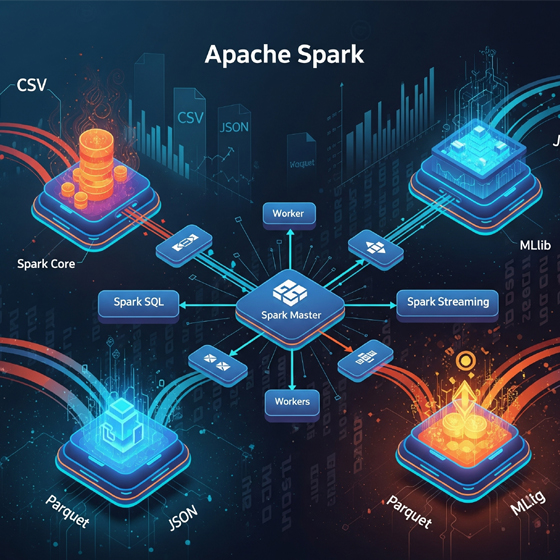

La arquitectura de Apache Spark se asienta sobre pilares bien definidos que garantizan su eficiencia, escalabilidad y tolerancia a fallos.

En el corazón de Spark se encuentran los Resilient Distributed Datasets (RDDs). Estos son abstracciones fundamentales que representan colecciones de objetos inmutables y distribuidas que pueden procesarse en paralelo a través de un clúster. La resiliencia y tolerancia a fallos de los RDDs se logra a través de la «información de linaje» (lineage information). Este mecanismo permite a Spark rastrear las transformaciones aplicadas a los conjuntos de datos. En caso de que una partición de datos se pierda debido a un fallo de nodo, Spark puede reconstruir esa partición específica utilizando la información de su linaje, evitando así la necesidad de volver a leer costosos datos desde el disco o reiniciar todo el proceso. Los RDDs, por defecto, se almacenan en memoria para un acceso rápido, pero pueden desbordarse a disco si la memoria disponible es insuficiente.

Otro componente arquitectónico vital es el motor de ejecución de Grafo Acíclico Dirigido (DAG). Spark utiliza un motor DAG avanzado que soporta flujos de datos acíclicos y computación en memoria. El DAG scheduler es responsable de optimizar la programación de tareas a través del clúster, lo que reduce la sobrecarga y mejora el tiempo de ejecución general del trabajo. Las dependencias entre RDDs, clasificadas como «estrechas» (narrow dependency) o «amplias» (wide dependency), son cruciales para la optimización del pipeline. Las dependencias estrechas, donde cada partición de un RDD padre es utilizada por una única partición del RDD hijo, facilitan la optimización al permitir la fusión de procesos y la eliminación de la materialización física de muchos resultados intermedios de RDD. Esto reduce la cantidad de barreras globales y mejora significativamente el rendimiento, un proceso conocido como optimización de pipeline en Spark.

La operación de Spark se basa en una arquitectura Maestro/Trabajador. En este modelo de computación en clúster, un programa controlador (driver program) es el encargado de lanzar y coordinar las operaciones paralelas que se ejecutan en un conjunto de nodos trabajadores (worker nodes).

La interacción entre los RDDs y el motor DAG constituye la base de la eficiencia y resiliencia de Spark. Los RDDs, al ser inmutables y mantener un registro de su linaje, garantizan que, en caso de un fallo, el sistema no necesite un reinicio completo del trabajo. En su lugar, solo se requiere la recomputación de las porciones de datos afectadas, lo que minimiza el impacto del fallo. Por otro lado, el motor DAG optimiza la secuencia y el encadenamiento de las operaciones sobre estos RDDs. Esto incluye la minimización del movimiento de datos innecesario, especialmente las costosas operaciones de «shuffle» (redistribución de datos entre nodos), y la maximización del procesamiento de datos en memoria. Esta sinergia es fundamental para lograr la alta eficiencia de Spark en cargas de trabajo iterativas y para asegurar la robustez del sistema frente a fallos.

Comandos más importantes usando Python (PySpark)

Para trabajar con PySpark, primero necesitas un SparkSession, que es el punto de entrada para programar Spark con la API de DataFrame y Dataset.

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, sum, avg

# Crear una SparkSession

# appName: Nombre de la aplicación Spark

# master: Define el modo de ejecución (local[*] para usar todos los cores locales, yarn, mesos, k8s, etc.)

spark = SparkSession.builder \

.appName("MiPrimerSparkApp") \

.master("local[*]") \

.getOrCreate()

# Deshabilitar logs excesivos (opcional, útil para la limpieza de la salida)

spark.sparkContext.setLogLevel("ERROR")

print("SparkSession creada exitosamente!")Operaciones básicas con DataFrames

Un DataFrame de Spark es una colección distribuida de datos organizada en columnas con nombre. Es conceptualmente equivalente a una tabla en una base de datos relacional o un DataFrame en R/Python (Pandas), pero con capacidades de optimización y escalabilidad mucho mayores.

1. Crear un DataFrame:

# Crear un DataFrame a partir de una lista de tuplas

data = [("Alice", 1, 100), ("Bob", 2, 200), ("Charlie", 3, 150), ("Alice", 1, 50)]

columns = ["Name", "ID", "Score"]

df = spark.createDataFrame(data, columns)

print("DataFrame creado:")

df.show()- Mostrar el esquema del DataFrame:

print("Esquema del DataFrame:")

df.printSchema()- Seleccionar columnas:

print("Seleccionar 'Name' y 'Score':")

df.select("Name", "Score").show()

# O usando la notación de columna

df.select(col("Name"), col("Score")).show()- Filtrar filas:

print("Filtrar por Score > 100:")

df.filter(df.Score > 100).show()

# O usando la notación de columna

df.filter(col("Score") > 100).show()- Agrupar y agregar datos:

print("Agrupar por Nombre y calcular la suma del Score:")

df.groupBy("Name").agg(sum("Score").alias("Total_Score")).show()

print("Agrupar por ID y calcular el promedio del Score:")

df.groupBy("ID").agg(avg("Score").alias("Average_Score")).show()- Añadir una nueva columna:

from pyspark.sql.functions import lit

print("Añadir una columna 'Status':")

df_with_status = df.withColumn("Status", lit("Active"))

df_with_status.show()- Eliminar una columna:

print("Eliminar la columna 'ID':")

df_no_id = df.drop("ID")

df_no_id.show()- Ordenar un DataFrame:

print("Ordenar por Score en orden descendente:")

df.orderBy(col("Score").desc()).show()- Escribir un DataFrame a un archivo (por ejemplo, Parquet):

# Nota: Esto escribirá un directorio con archivos parquet dentro.

# Para evitar errores si el directorio ya existe, se usa mode("overwrite")

output_path = "output_data/scores_parquet"

df.write.mode("overwrite").parquet(output_path)

print(f"DataFrame guardado en {output_path}")

# Para leerlo de nuevo:

# df_read = spark.read.parquet(output_path)

# print("DataFrame leído desde Parquet:")

# df_read.show()Caso de Uso Pequeño: Análisis de Ventas Simplificado

Imaginemos que tenemos un archivo CSV con datos de ventas y queremos calcular las ventas totales por producto y por región.

Datos de entrada (crear un archivo sales_data.csv):

Product,Region,Sales

Laptop,North,1200

Mouse,South,50

Keyboard,North,75

Laptop,South,1500

Mouse,North,60

Monitor,East,300

Laptop,East,1000Código PySpark para el análisis:

# Asegúrate de que el archivo sales_data.csv esté en la misma ubicación

# o proporciona la ruta completa.

# Leer el archivo CSV en un DataFrame

sales_df = spark.read \

.option("header", "true") \

.option("inferSchema", "true") \

.csv("sales_data.csv")

print("Datos de ventas originales:")

sales_df.show()

sales_df.printSchema()

# 1. Calcular las ventas totales por Producto

sales_by_product = sales_df.groupBy("Product").agg(sum("Sales").alias("TotalSales"))

print("Ventas totales por Producto:")

sales_by_product.show()

# 2. Calcular las ventas totales por Región

sales_by_region = sales_df.groupBy("Region").agg(sum("Sales").alias("TotalSales"))

print("Ventas totales por Región:")

sales_by_region.show()

# 3. Calcular las ventas promedio por Región

avg_sales_by_region = sales_df.groupBy("Region").agg(avg("Sales").alias("AverageSales"))

print("Ventas promedio por Región:")

avg_sales_by_region.show()

# 4. Encontrar el producto más vendido en cada región (ejemplo más avanzado)

from pyspark.sql.window import Window

from pyspark.sql.functions import rank

window_spec = Window.partitionBy("Region").orderBy(col("Sales").desc())

product_rank = sales_df.withColumn("rank", rank().over(window_spec))

top_product_per_region = product_rank.filter(col("rank") == 1).drop("rank")

print("Producto más vendido por Región:")

top_product_per_region.show()

# Detener la SparkSession al finalizar

spark.stop()

print("SparkSession detenida.")Conclusiones y Perspectivas Futuras

Apache Spark ha transformado fundamentalmente el panorama del procesamiento de Big Data, estableciéndose como una plataforma unificada, rápida y flexible. Su diseño innovador ha impulsado la analítica avanzada, el machine learning y el procesamiento de datos en tiempo real en una diversidad de industrias. Al aprovechar el procesamiento en memoria y un motor de Grafo Acíclico Dirigido (DAG), Spark ha abordado y resuelto cuellos de botella inherentes a frameworks anteriores, permitiendo a las organizaciones extraer valor de volúmenes de datos sin precedentes.

La evolución continua de Spark se entrelaza intrínsecamente con el surgimiento de arquitecturas de datos modernas, como los «data lakehouses». Estas arquitecturas buscan combinar la flexibilidad de los data lakes, que almacenan datos en su formato original y a bajo costo, con la estructura, el rendimiento y las capacidades de gobernanza de los data warehouses tradicionales. Spark, con su capacidad inherente para procesar tanto datos estructurados como no estructurados y su creciente integración con formatos de tabla abiertos como Apache Iceberg y Delta Lake, se ha convertido en un componente central de estas arquitecturas emergentes. Esta integración permite a las empresas construir plataformas de datos más ágiles y eficientes que pueden soportar una gama más amplia de cargas de trabajo analíticas y de inteligencia artificial.

Además, la integración de Spark con plataformas de MLOps (Machine Learning Operations) en la nube, como Google Cloud Vertex AI, Azure Machine Learning y Amazon SageMaker, subraya su papel indispensable en la operacionalización de modelos de inteligencia artificial a escala. Estas plataformas abordan desafíos críticos como la reproducibilidad de los experimentos de machine learning, la escalabilidad de los modelos en producción y el monitoreo continuo de su rendimiento y deriva de datos. La capacidad de Spark para manejar grandes volúmenes de datos y ejecutar algoritmos complejos lo posiciona como un motor fundamental para la infraestructura de MLOps, garantizando que los modelos de IA puedan desarrollarse, implementarse y mantenerse de manera eficiente y confiable a lo largo de su ciclo de vida.

En síntesis, Apache Spark no solo ha demostrado ser una herramienta transformadora para el procesamiento de datos a gran escala, sino que continúa siendo un pilar estratégico para las empresas que buscan una ventaja competitiva a través de la inteligencia de datos. Su comunidad activa y su constante evolución, adaptándose a las nuevas arquitecturas y necesidades del mercado, aseguran su relevancia y liderazgo en el futuro del procesamiento de datos.

—————————————-

Fuentes: